盖世汽车讯 据外媒报道,近日,中国天津职业技术师范大学(Tianjin University of Technology and Education)、山东交通职业学院(Shandong Transport Vocational College)和天津中德应用科技大学(Tianjin Sino-German University of Applied Sciences)的研究人员讨论到,将光探测和测距(LiDAR激光雷达)与摄像头传感器相集成对提高自动驾驶汽车的物体探测能力的重要性。此种传感器融合技术将激光雷达点云数据和RGB(红、绿、蓝)摄像头图像集成在一起,旨在提高自动驾驶汽车在不同环境条件下的探测精度和可靠性。

图片来源于网络,如有侵权,请联系删除

传感器融合(图片来源:azosensors.com)

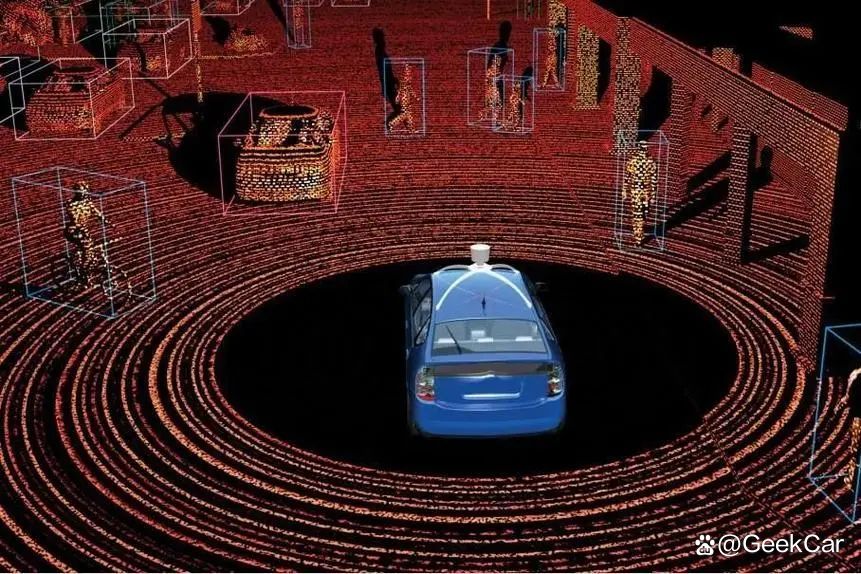

自动驾驶汽车技术的进步促进了人们对强大物体探测和跟踪系统的需求不断增长,以确保自动驾驶汽车可在各种环境条件下安全、高效地运行。传统的物体探测系统通常依赖激光雷达或摄像头等单个传感器,而这类传感器都具有各自的优势和局限性。激光雷达传感器可以提供精确的深度信息,但在恶劣天气条件或低光照环境下可能会遇到困难。

为了克服此类单个传感器的局限性以及提升探测能力,通过融合技术集成多个传感器已成为一种有发展前景的解决方案。激光雷达-摄像头传感器融合技术结合了激光雷达的深度感知能力以及摄像头所捕捉到的视觉信息。

图片来源于网络,如有侵权,请联系删除

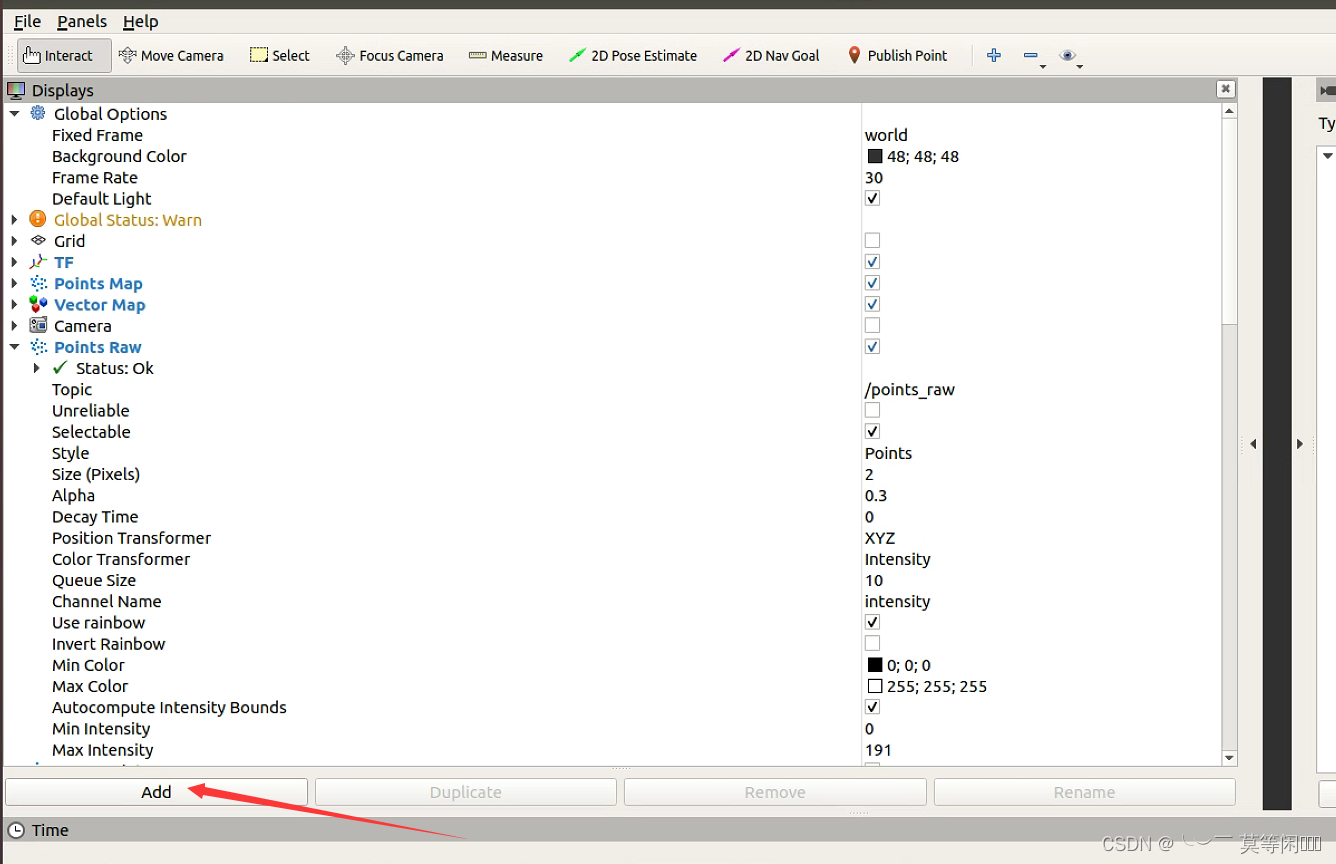

在该项研究中,研究人员通过激光雷达-摄像头传感器融合技术,来提升自动驾驶汽车的物体探测能力。该技术采用了一种综合方法,将激光雷达点云的数据与RGB摄像头图像集成在一起。

研究人员使用KITTI数据集收集数据,该数据集提供了同步的激光雷达点云数据和RGB图像以及内部和外部的传感器参数,帮助摄像头和激光雷达设备进行校准,从而实现坐标系之间的精确投影。此外,研究人员还采用自己采集到的数据,在现实场景中验证PointPillars算法的探测性能。

研究人员采用了两种最先进的深度学习模型用于物体探测:用于激光雷达点云数据处理的PointPillars以及用于分析摄像头捕捉到的RGB图像的YOLOv5。PointPillars网络基于激光雷达数据生成3D物体探测结果,而YOLOv5基于摄像头图像提供2D物体探测结果。此类结果相融合对于实现全面的物体探测至关重要。

结果融合过程包括使用联合校准参数,将激光雷达的3D物体检测框投射到由摄像头捕捉到的2D图像上。研究人员采用目标边界框相交重叠(IOU评价函数)匹配策略,将激光雷达和摄像头的探测结果融合在一起,再采用结合了Dempster-Shafer(D-S)理论的融合算法,结合类别置信度,产生最终的融合探测输出结果。

对于跟踪移动物体,研究人员改进了DeepSORT算法,以解决遮挡后动态物体重新出现产生的身份切换问题。改进后的DeepSORT算法采用了一个无迹卡尔曼滤波器(Unscented Kalman Filter)来进行状态估计,提高了在动态场景下的跟踪精度。

研究人员设置的实验分析了融合算法在不同日间场景下的性能,将融合结果与单传感器探测的结果进行比较,以评估该融合方法在更准确地包裹汽车和行人目标方面的有效性,另外还采用了多物体跟踪准确度(MOTA)、多物体跟踪精度(MOTP)、高阶跟踪精度(HOTA)以及集成式探测与跟踪F1分数(IDF1)等性能指标来评估该跟踪算法的效率。

在日间场景中,该融合算法将激光雷达和摄像头数据高效结合,以产生更加全面且准确的物体探测结果。融合结果表明,与单传感器探测相比,目标边界框可以更好地包裹汽车和行人目标,探测性能得以提升对于确保自动驾驶系统在各种日间场景中的安全性和高效率至关重要。

在灯光昏暗的夜间场景中,激光雷达和摄像头数据的融合显得尤为重要。该融合算法成功补足了单个传感器的局限性,特别是在探测行人和车辆目标的情况下。融合结果显示出较强的识别效果,能够更完整地包裹目标,提高了低光照环境下的整体探测能力。

基于D-S证据理论的统计分析法为融合过程提供了宝贵的见解,该融合策略有效地结合了激光雷达和摄像头数据的类别置信度,从而提高了物体探测能力。此类融合结果表明,该方法探测到汽车和行人的概率更高,表明了该融合算法在提升探测精度方面具有鲁棒性。

该研究还评估了跟踪算法在动态目标跟踪场景下的性能,特别是得到改进的DeepSORT算法的性能。研究人员采用MOTA、MOTP、HOTA和IDF1等指标对不同的跟踪方法进行了比较,凸显了得到改进的DeepSORT算法在准确跟踪动态目标、减少身份切换问题以及提升整体跟踪性能方面的有效性。

专题推荐:

推荐阅读: